Location

线上活动

Time

04/17 周四 06:00 ~ 09:30

直播链接将会在开播前15分钟微信群通知大家

会议链接:https://meituan.zoom.us/j/98702314400

会议号:987 023 14400 密码:0417

报名成功后添加“小助手”微信进群(获取视频号直播)

![]()

| 关于美团技术沙龙

活动由清华大学-美团数字生活联合研究院和深圳市美团机器人研究院联合出品,美团技术团队和美团科协主办。

技术沙龙论文分享会将精选美团在不同领域学术会议上发表的论文,邀请作者分享研究成果,期待与大家交流经验,共同促进技术前沿的探索。

本期活动为 ICLR & CVPR 2025 专场。

论文下载可以在【美团技术团队】公众号查看:请点击这里

/出品人/

Xiaoming Wei,美团研究员

致力于美团视觉 AI 技术能力建设及应用落地,在视觉感知、内容理解、视觉生成等多个分支领域有丰富的经验,曾多次获得省部级科技进步奖项。

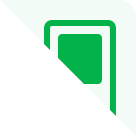

| 日程安排

![]()

| 分享介绍

Jie Hu, 美团高级算法专家

从事视觉生成与多模态理解方向的研究

Denoising with a Joint-Embedding Predictive Architecture

联合表征预测框架的去噪方法

论文简介:

联合表征预测架构(JEPAs)在自监督表示学习中表现出显著的潜力,但它们在生成建模中的应用仍未被充分探索。相反,扩散模型在建模任意概率分布方面表现出了显著的效果。在本文中,我们介绍了一种结合联合表征预测架构的去噪方法(DJEPA),在生成建模中首次尝试整合 JEPA。通过将 JEPA 视为一种掩蔽图像建模,我们将其重新理解为广义的下一个标记预测策略,从而以自回归的方式便捷地进行数据生成。此外,我们结合了扩散损失以建模每个标记的概率分布,使得数据在连续空间中生成。我们还采用流匹配损失作为扩散损失的替代方案,从而增强了 D-JEPA 的灵活性。实验结果表明,随着 GFLOPs 的增加,D-JEPA 能够在更少的训练周期内稳定地达到较低的 FID 分数,显示出其良好的可扩展性。我们的基础模型、大型模型和超大型模型在 ImageNet 条件生成基准上的所有规模上均优于所有先前的生成模型。除了图像生成,D-JEPA 还适合其他连续数据建模,包括视频和音频。

-----------------------------

Junjie Liu,美团技术专家

从事无人机云端感知,模型压缩,以及 VLM 应用多个分支均有落地经验

Diffusion-4K: Ultra-High-Resolution Image Synthesis with Latent Diffusion Models

4K扩散:基于潜在空间扩散模型的超高分辨率图像生成

论文简介:

基于 Diffusion 的图像生成范式目前在超分辨率图像的生成仍存在纹理细节不足,结构化纹理存在artifacts以及显存占用过大等问题,同时也缺乏超分辨率图像生成 Benchmark 用于对此类问题的客观评估。本文提出了首个面向 4K 超分辨率图像,用于评估图像局部细节以及结构完整性的 Benchmark,称为 Aesthetic-4K。同时提出了一个基于小波变换的 Diffusion Generation 范式和高效的分块VAE用于解决所述问题,使得能在消费级显卡(如NVIDIA 4090)上实现 Flux-12B 的 4K 高清图像生成。

-----------------------------

Zining Wang,美团算法工程师

从事 OCR、文档理解多模态大模型研究

Marten: Visual Question Answering with Mask Generation for Multi-modal Document Understanding

Marten:通过掩码生成实现多模态文档理解的视觉问答

论文简介:

多模态大型语言模型(MLLMs)为文档理解引入了一个新的维度,即它们赋予大型语言模型以视觉理解能力。然而,对于如何在文档级别的 MLLMs 中设计一个合适的图像-文本预训练任务,以桥接视觉和语言模态的问题仍然缺乏探索。在这项研究中,我们引入了一种新的视觉-语言对齐方法,该方法将关键问题归结为一种视觉问答与掩码生成(VQAMask)任务,从而同时优化两个任务:基于 VQA 的文本解析和掩码生成。前者使模型能够在语义层面上隐式地对齐图像和文本。后者则引入了一个额外的掩码生成器(在推理阶段被弃用),以显式地确保图像中的视觉文本与其对应的图像区域在空间感知层次上的对齐。两者结合可以防止模型在解析视觉文本时出现幻觉,并有效促进空间感知特征表示的学习。为支持所提出的 VQAMask 任务,我们构建了一个全面的图像-掩码生成流水线,并提供了一个包含600万数据的大规模数据集(MTMask6M)。随后,我们证明了引入所提出的掩码生成任务可以带来有竞争力的文档级理解性能。利用所提出的 VQAMask,我们引入了 Marten,一种为文档级理解量身定制的训练高效的 MLLM。广泛的实验表明,在以文档为中心的任务中,我们的 Marten 在 8B-MLLMs 中始终实现了显著的改进。

-----------------------------

Hongyu Li,北京航空航天大学人工智能学院硕士在读

从事多模态大语言模型研究

LLaVA-ST: A Multimodal Large Language Model for Fine-Grained Spatial-Temporal Understanding

LLaVA-ST: 用于细粒度时空理解的多模态大模型

论文简介:

多模态大语言模型在时空细粒度理解任务中存在核心挑战:1. 时空坐标组合爆炸性增长导致的跨模态对齐难 2.视频特征压缩过程中细粒度信息保真度不足。方法通过以下核心创新点解决上述关键难题:1. 语言对齐位置嵌入(Language-Aligned Positional Embedding),通过将文本坐标特殊标记嵌入视觉特征空间,显著简化了细粒度时空对应关系的对齐过程;2.时空特征打包器(Spatial-Temporal Packer),将时空分辨率特征压缩解耦为两个时空独立的点-区域注意力处理流;3. 粒度从粗到细的三阶段训练策略,内容对齐->坐标对齐->细粒度多任务微调。为提升模型对复杂时空关系的理解能力,我们构建了包含 4.3M 样本的 ST-Align 数据集,并提出包含时空视频定位(STVG)、事件定位与描述(ELC)、空间视频定位(SVG)多维度的 MLLM 时空交错理解 Benchmark。实验结果表明,LLaVA-ST在涉及细粒度时序理解、空间定位及时空交错多模态理解等11类基准测试中均展现出卓越性能,展示了其在视频理解、具身智能、自动驾驶等领域的广泛应用潜力。

-----------------------------

Wei Wang,美团算法工程师

从事 AIGC 模型的质量评估

Q-Eval-100K: Evaluating Visual Quality and Alignment Level for Text-to-Vision Content

Q-Eval-100k: 评估文本到视觉内容生成的视觉质量与一致性

论文简介:

评估文本到视觉内容的生成效果主要取决于两个关键的方向:视觉质量和对齐度,尽管之前已经发表过很多类似的工作用于评估这些维度,并且也取得了一定的进展,但此类模型的性能很大程度上都依赖于人工标注的规模和质量;有一定证据表明,数据质量和标注规模的上升,将有助于提升评估模型的性能,因此,我们构建了目前规模最大的 AIGC 质量评估数据集 Q-EVAL-100K 以及对应的统一 AIGC 视觉评估框架 Q-Eval-Score,该数据集包含了 100k(6 万张图像和 4 万个视频)的人工标注分数,并着重关注对齐度和视觉质量;在这个大规模数据集的基础上,评估框架 Q-Eval-Score 在 AIGC 图像/视频的视觉质量评估和对齐度评估上都取得了相当优异的性能。

-----------------------------

Zijian Zhang,美团高级算法工程师

从事大模型落地应用,大模型能力评估

TokenFocus-VQA: Enhancing Text-to-Image Alignment with Position-Specific Focus and Multi-Perspective Aggregations on LVLMs

TokenFocus-VQA:基于位置聚焦的多模态大模型对齐方法

论文简介:

目前基于全局相似性度量的方法往往忽略了文本描述和视觉内容之间关键的 Token 级对应关系,为此,我们推出了 TokenFocus-VQA,通过视觉问答范式并结合位置特定的概率优化大型视觉语言模型。我们的关键创新在于设计了一种 Token 感知损失函数,该函数有选择性地关注对应于关键语义元素的预定义词汇位置的概率分布,从而实现精确衡量细粒度语义对齐。该框架进一步整合了集成学习技术,从不同的LVLM架构中汇聚多视角评估,从而实现性能的进一步提升。在 NTIRE 2025 T2I 质量评估基准上进行评估时,我们的 TokenFocus-VQA 在公共评估中排名第二(84.45%,仅比第一名低0.01%),在官方私有测试集上排名第二(84.26%),相比传统评估方法,展现了在捕捉细微文本与图像对应关系上的优越性。

-----------------------------

Ruichen Shao,美团算法工程师

从事大模型 Post Training

Earlier Tokens Contribute More: Learning Direct Preference Optimization From Temporal Decay Perspective

早期词元贡献更大:时序衰减视角下的直接偏好优化学习

论文简介:

直接偏好优化(DPO)作为一种高效替代基于人类反馈的强化学习(RLHF)的方法,在大语言模型(LLMs)与人类偏好对齐方面受到关注。尽管具有优势,DPO 存在长度偏差问题,其生成的响应往往比参考模型更长。现有解决方案如 SimPO 和 SamPO 虽然解决了这一问题,但统一对待序列中各奖励的贡献,忽略了时序动态特性。为此,我们提出一种改进的偏好优化方法,引入由 Gamma 参数控制的时序衰减因子。这种动态加权机制根据奖励在序列中的位置调整其影响力,优先考虑对对齐更关键的早期词元。通过自适应聚焦更相关的反馈,我们的方法减轻了对次要数据的过拟合,同时保持对人类偏好演变的响应能力。在多个基准测试上的实验结果表明,我们的方法在不同模型架构和规模下,相较原始 DPO 在 AlpacaEval 2 上持续提升5.9-8.8分,在 Arena-Hard 上提升 3.3-9.7 分。此外,在数学推理基准(MMLU、GSM8K和MATH)上的补充实验证实,该方法在提升性能的同时不会损害模型的通用能力。

| 报名方式

点击本页面报名,美团同学无需报名,内部大象会有通知~

往期活动PPT及视频干货攻略

美团技术沙龙已举办了80多场,吸引了10万多工程师报名参会,覆盖前端、后台、系统、算法、测试、运维等技术领域,往期PPT及视频资料已整理,欢迎关注美团技术团队公众号(meituantech),通过【菜单栏】下的【技术沙龙】进行查看。

关于PPT和回放

1. 活动结束后,PPT和回放视频 将会上传至「美团技术团队」小程序,可扫码查看~

2. B站 回放视频 可点击:https://b23.tv/XEm1VvF

Event Inquiry

Question

The specific services and content of this event are provided by the organizer 【美团技术团队】. Huodongxing only provides ticketing technical support. Please read the event details carefully before participating.

If any issues or disputes arise during the event participation, both parties should communicate amicably and may contact Huodongxing for assistance

3.We welcome reports concerning fake events, content infringement, and other such behaviors; upon verification, Huodongxing reserves the right to impose account restrictions or remove content as necessary.